Test d’indexation d’une page bloquée par le Robots.txt

Par l’intermédiaire d’un nouveau test, nous avons voulu savoir si une page pouvait s’indexer et se positionner sur une requête bien qu’elle soit bloquée par l’intermédiaire du fichier Robots.txt. Vous pouvez trouver ci-dessous les conclusions auxquelles nous avons abouti.

Méthodologie

- Détection d’un répertoire bloqué dans le robots.txt d’un de nos sites de test

- Envoi de liens externes sur une URL cible inexistante incluse dans le répertoire bloqué

- Utilisation d’une expression inexistante comme ancre de lien

- Suivi de l’indexation et du positionnement de l’URL sur l’expression contenue dans l’ancre

Résultat : l’URL bloquée ressort sur l’expression visée

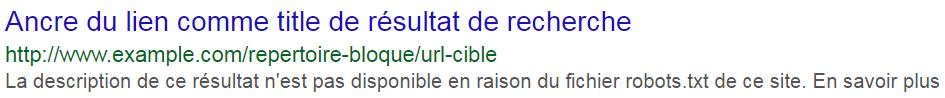

L’URL s’est bien indexée et s’est également positionnée sur la requête contenue dans l’ancre des liens. L’ancre en question est aussi reprise dans la balise title affichée par Google dans ses résultats de recherche. Comme pour toute URL bloquée dans le Robots.txt d’un site, Google indique en revanche bien le message précisant qu’il n’a pas accès à cette dernière :

Format du résultat de recherche Google pour l’URL cible du test

Format du résultat de recherche Google pour l’URL cible du test

Conclusion : le Robots.txt n’empêche pas l’indexation d’une URL

Ces résultats prouvent que bloquer une URL par l’intermédiaire du fichier Robots.txt n’empêchera pas nécessairement son indexation. Si l’URL en question reçoit des liens externes, elle est alors susceptible de s’indexer et de se positionner.